Khi Microsoft đầu tư 1 tỷ USD vào OpenAI năm 2019, họ đã đồng ý xây dựng một siêu máy tính tiên tiến với hiệu năng siêu mạnh dành cho startup nghiên cứu trí tuệ nhân tạo ChatGPT.

Vấn đề duy nhất – Microsoft không có được bất cứ máy tính nào OpenAI cần và cũng không chắc họ có thể tạo ra được cỗ máy nào đủ lớn trên đám mây Azure mà không làm hỏng nó.

Thời điểm đó OpenAI đang bắt tay vào huấn luyện các mô hình AI lớn, cần hấp thụ một lượng dữ liệu khổng lồ, học hỏi ngày càng nhiều tham số và các biến số hơn trong quá trình huấn luyện. Điều đó nghĩa là OpenAI cần có được khả năng điện toán đám mây cực mạnh trong một thời gian dài.

Siêu máy tính AI từ hàng chục nghìn GPU

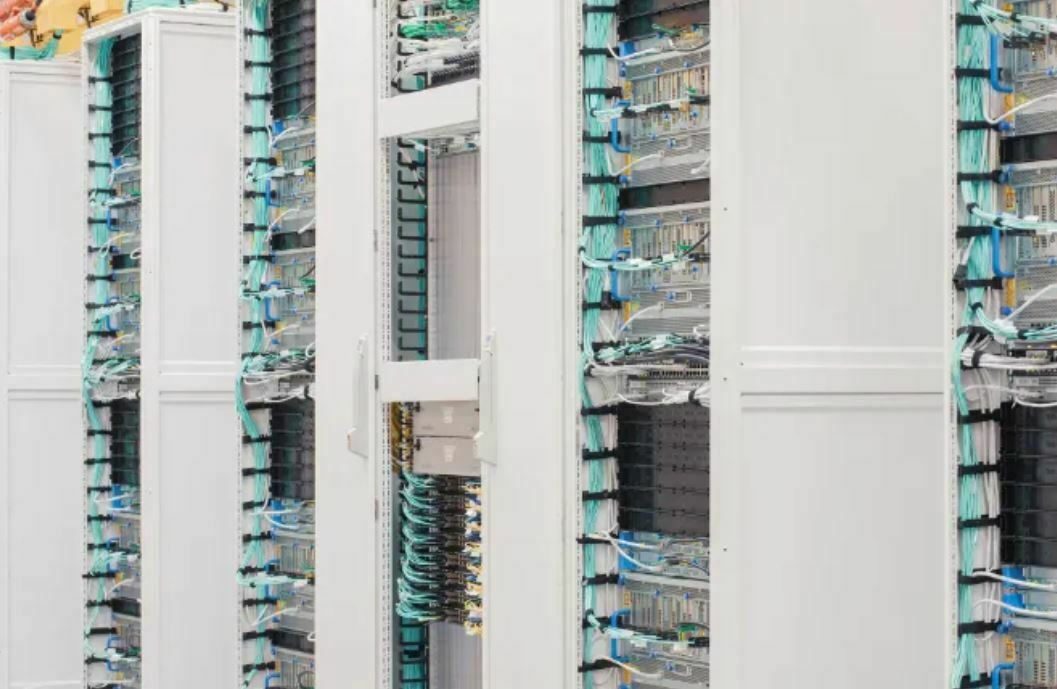

Để vượt qua thách thức này, Microsoft phải tìm cách liên kết khả năng xử lý của hàng chục nghìn GPU Nvidia A100 với nhau – những con ngựa thồ giá 10.000 USD dành cho việc huấn luyện các mô hình AI. Số lượng khổng lồ các chip đồ họa Nvidia A100 này còn buộc công ty phải tính toán đến cách sắp xếp máy chủ trên giá đỡ để đảm bảo nguồn điện không bị quá tải.

Dù không tiết lộ chính xác chi phí cho dự án này, nhưng theo ông Scott Guthrie, phó chủ tịch về đám mây và AI của Microsoft, con số này có thể còn lớn hơn mức vài trăm triệu USD.

Bà Nidhi Chappell, tổng giám đốc Microsoft về cơ sở hạ tầng Azure AI, cho biết: “Chúng tôi đã xây dựng nên một kiến trúc hệ thống có thể vận hành và trở nên đáng tin cậy ở quy mô vô cùng lớn. Điều đó đã giúp biến ChatGPT trở nên khả thi. Đã có một mô hình bước ra từ đó. Sẽ còn nhiều, nhiều mô hình khác nữa.”

Lời khẳng định đó đang dần trở thành sự thật. Hệ thống được Microsoft xây dựng để huấn luyện nên ChatGPT giờ đang được sử dụng để huấn luyện và vận hành các mô hình AI lớn khác, bao gồm chatbot Bing Chat mới được giới thiệu tháng trước. Bên cạnh đó, Microsoft còn bán hệ thống này cho các công ty khác để họ huấn luyện các mô hình của riêng mình.

Huấn luyện các mô hình AI khổng lồ cần đến một lượng lớn các bộ xử lý đồ họa được kết nối với nhau thành một siêu máy tính AI. Không chỉ vậy, ngay cả việc trả lời các truy vấn của người dùng cũng buộc các mô hình phải suy luận – nghĩa là cũng cần đến khả năng tính toán của các chip đồ họa này – tuy nhiên lại phải có một chút thay đổi về thiết kế hệ thống.

Microsoft cũng thiết lập các bộ xử lý đồ họa dành riêng cho khả năng suy luận của mô hình AI khi trả lời truy vấn – nhưng hàng trăm nghìn GPU này không tập trung tại một địa điểm mà phân tán trong hơn 60 trung tâm dữ liệu nằm rải rác ở nhiều nơi của công ty. Giờ đây công ty còn đang bổ sung thêm GPU mới nhất của Nvidia dành cho AI – các GPU H100 – phiên bản mới nhất trang bị công nghệ mạng lưới Infiniband của Nvidia để chia sẻ dữ liệu tốc độ siêu cao.

… và vô vàn chi tiết nhỏ không tên

Để xây dựng nên hệ thống điện toán đám mây khổng lồ như vậy sẽ cần đến hàng ngàn linh kiện bộ phận khác nhau – ngay cả loại giá để máy chủ, đường ống dây, bê tông cho các tòa nhà, các loại kim loại vật liệu khác nhau – chỉ một chút chậm trễ trong bất kỳ linh kiện nào cũng có thể gây ra lỗi trên hệ thống.

Gần đây, đội lắp đặt đã phải đối phó với tình trạng thiếu máng cáp – vật dụng giống như cái giỏ kích thước lớn được dùng để đựng các sợi cáp khi đi dây trên trần nhà. Vì vậy họ phải thiết kế một loại máng cáp mới mà Microsoft có thể tự sản xuất hoặc mua ở nơi khác nhằm bù đắp chỗ thiếu hụt này. Ông Guthrie cũng cho biết, công ty đang nghiên cứu cách để loại bỏ càng nhiều máy chủ càng tốt ở các trung tâm dữ liệu hiện tại trên toàn cầu, vì vậy họ không phải chờ đợi xây dựng các tòa nhà mới.

Không chỉ như vậy, khi siêu máy tính AI trên đám mây Azure của Microsoft bắt đầu hoạt động, nghĩa là mọi cỗ máy sẽ vào guồng quay của mình cùng một lúc. Để đảm bảo mọi cỗ máy được vận hành cùng lúc, Microsoft phải tính toán về vị trí mọi thứ – từ các con chip xử lý cho đến nguồn điện và cả hệ thống làm mát cho chúng – mọi bộ phận, mọi linh kiện phải ở vị trí hợp lý để việc vận hành diễn ra ổn định.

Nếu không, ông Guthrie cho biết, trung tâm dữ liệu của bạn sẽ biến thành một sự kết hợp khổng lồ giữa lò vi sóng, máy nướng bánh mỳ và máy hút bụi trong một nhà bếp.

Hiện tại Microsoft vẫn đang phát triển các máy chủ và thiết kế chip tùy chỉnh cũng như cách thức tối ưu hóa chuỗi cung ứng của mình. Tất cả đều nhằm chuyển thành các cải thiện về tốc độ, hiệu quả và tiết kiệm chi phí nhất có thể.

Ông Guthrie cho biết: “Mô hình AI đang làm thế giới kinh ngạc hiện nay vốn được xây dựng trên siêu máy tính chúng tôi tạo ra nhiều năm trước. Các mô hình mới sẽ được xây dựng trên siêu máy tính mới chúng tôi đang huấn luyện, còn lớn hơn và có thiết kế tinh xảo hơn.”

Nguồn: VNR